I am a Ph.D student at KAIST AI advised by Seungryong Kim. My research interests lie in the intersection of computer vision and machine learning, particularly in 3D computer vision and generative models. My goal is to solve fundamental problems in 3D computer vision and apply them to real-world scenarios.

🎓 Education

KAIST Seoul, Korea

Sep. 2024 - PresentM.S/Ph.D Integrated Student in Artificial Intelligence

Korea University Seoul, Korea

Mar. 2024 - Aug. 2024Master Student in Computer Science and Engineering

Transferred to KAIST with supervisor

Korea University Seoul, Korea

Mar. 2020 - Feb. 2024B.S in Computer Science and Engineering

Highest Honor (Ranked 1st in College of Informatics)

🗂️ Experiences

Google Deepmind Zurich, Switzerland

May. 2026 - Nov. 2026, ExpectedStudent Researcher

Mentor: Thiemo Alldieck

📖 Publications

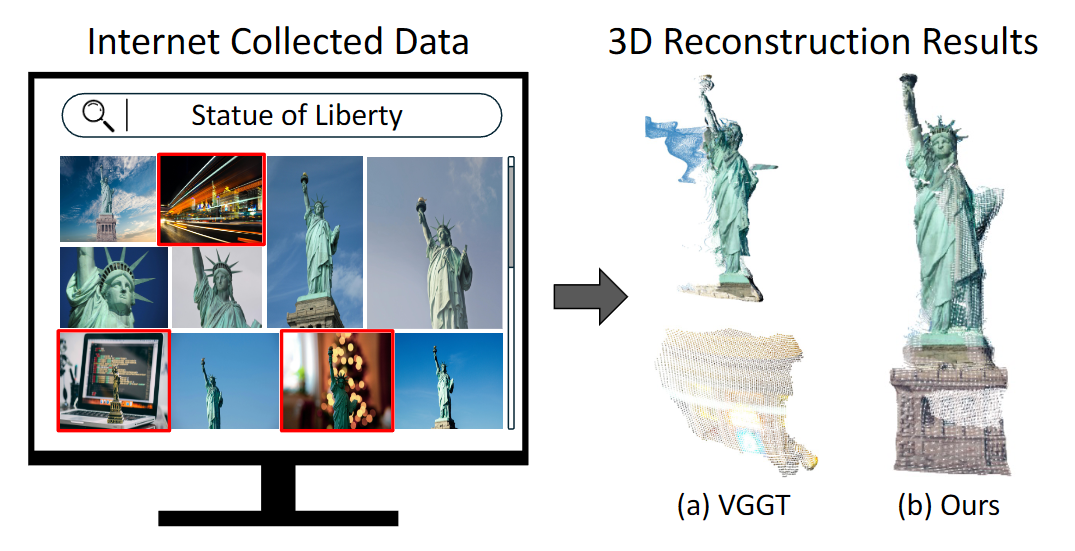

Emergent Outlier View Rejection in Visual Geometry Grounded Transformers

CVPR 2026

@article{han2025emergent,

title={Emergent Outlier View Rejection in Visual Geometry Grounded Transformers},

author={Han, Jisang and Hong, Sunghwan and Jung, Jaewoo and Jang, Wooseok and An, Honggyu and Wang, Qianqian and Kim, Seungryong and Feng, Chen},

journal={arXiv preprint arXiv:2512.04012},

year={2025}

}

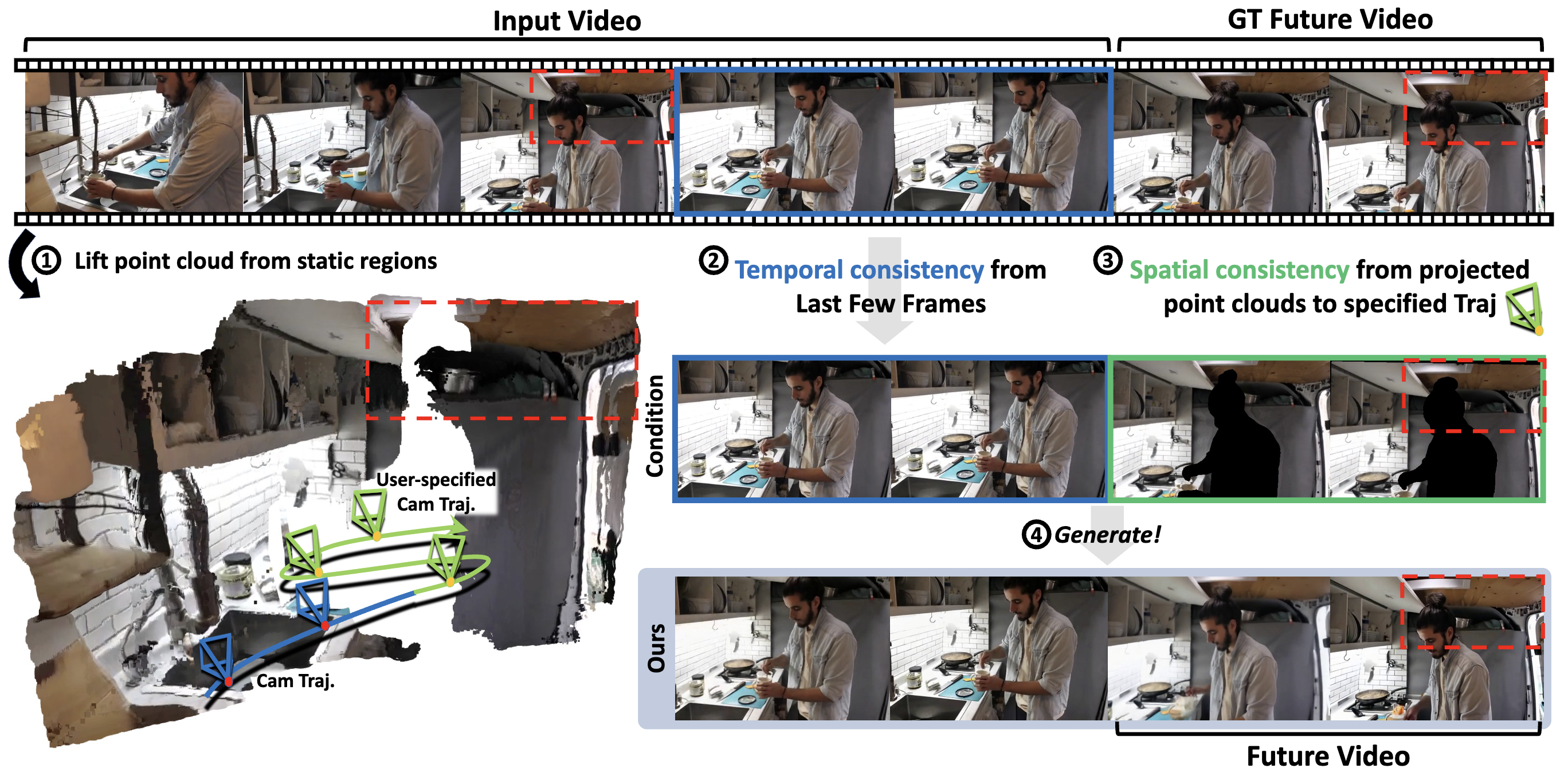

3D Scene Prompting for Scene-Consistent Camera-Controllable Video Generation

ICLR 2026

Video Camera Trajectory Editing with Generative Rendering from Estimated Geometry

AAAI 2026

Self-Evolving Neural Radiance Fields

ICCV 2025 Workshop on Wild 3D

@article{jung2023self,

title={Self-Evolving Neural Radiance Fields},

author={Jung, Jaewoo and Han, Jisang and Kang, Jiwon and Kim, Seongchan and Kwak, Min-Seop and Kim, Seungryong},

journal={arXiv preprint arXiv:2312.01003},

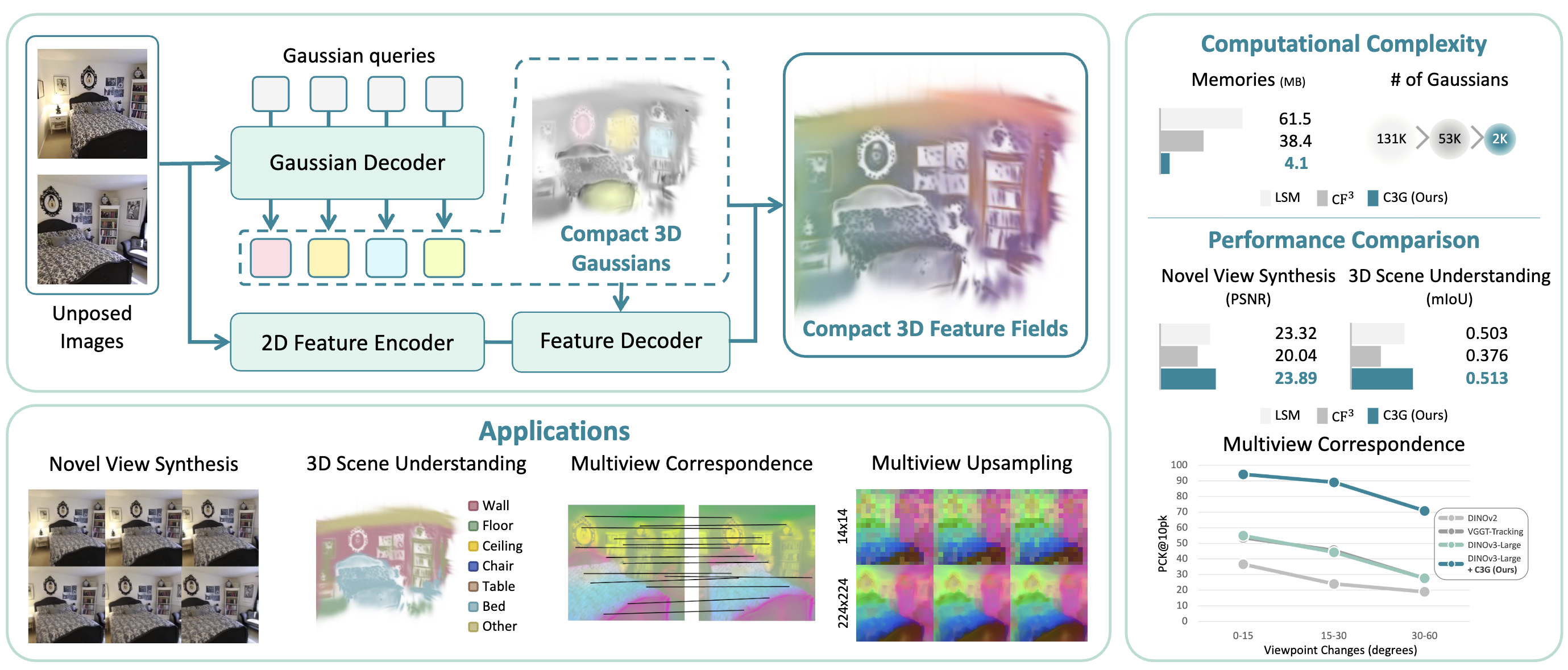

year={2023}}PF3plat: Pose-Free Feed-Forward 3D Gaussian Splatting

ICML 2025

@misc{hong2024pf3plat,

title={PF3plat: Pose-Free Feed-Forward 3D Gaussian Splatting},

author={Sunghwan Hong and Jaewoo Jung and Heeseong Shin and Jisang Han and Jiaolong Yang and Chong Luo and Seungryong Kim},

year={2024},

eprint={2410.22128},

archivePrefix={arXiv},

primaryClass={cs.CV}}

Cross-View Completion Models are Zero-shot Correspondence Estimators

CVPR 2025 Highlight ⭐

@misc{an2024crossviewcompletionmodelszeroshot,

title={Cross-View Completion Models are Zero-shot Correspondence Estimators},

author={Honggyu An and Jinhyeon Kim and Seonghoon Park and Jaewoo Jung and Jisang Han and Sunghwan Hong and Seungryong Kim},

year={2024},

eprint={2412.09072},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2412.09072},

}📗 Preprints

VIRAL: Visual Representation Alignment for Multimodal Large Language Models

ArXiv 2025

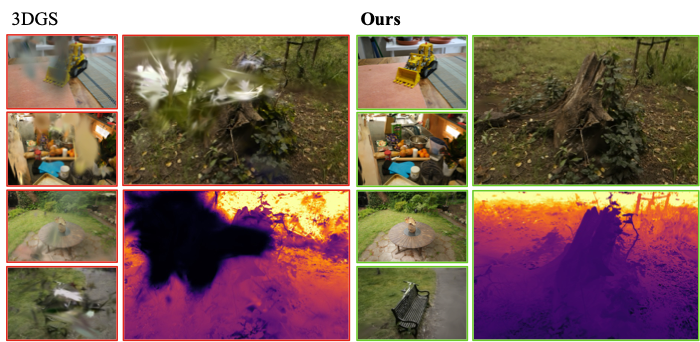

Relaxing Accurate Initialization Constraint for 3D Gaussian Splatting

ArXiv 2024

@misc{jung2024relaxing,

title={Relaxing Accurate Initialization Constraint for 3D Gaussian Splatting},

author={Jaewoo Jung and Jisang Han and Honggyu An and Jiwon Kang and Seonghoon Park and Seungryong Kim},

year={2024},

eprint={2403.09413},

archivePrefix={arXiv},

primaryClass={cs.CV}}